Сети с симметричными связями

1. Ансамблевые нейронные сети. Минский и Пейперт отмечали, что недостатки простых персептронов можно преодолеть как с помощью многослойных сетей, так и введением в сеть обратных связей, допускающих циркуляцию сигналов по замкнутым контурам. Использовать свойства такого рода сетей для моделирования функций мозга еще в 1949 г. предложил Хебб.

Согласно взглядам Хебба нервные клетки мозга соединены друг с другом большим количеством прямых и обратных возбуждающих связей и образуют нейронную сеть. Каждый нейрон осуществляет пространственно-временную суммацию приходящих к нему сигналов от возбужденных нейронов, определяя потенциал на своей мембране. Когда потенциал на мембране превышает пороговое значение, нейрон возбуждается. Нейрон обладает рефрактерностью и усталостью. Эффективность связей может изменяться в процессе функционирования сети, повышаясь между одновременно возбужденными нейронами. Это приводит к объединению нейронов в клеточные ансамбли - группы клеток, которые чаще всего возбуждались вместе, и к обособлению ансамблей друг от друга. При возбуждении достаточной части ансамбля он возбуждается целиком. Различные ансамбли могут пересекаться: один и тот же нейрон может входить в разные ансамбли. Электрическая активность мозга обусловлена последовательным возбуждением отдельных ансамблей.

Идеи Хебба оказали большое воздействие на представления о работе мозга и послужили основой для создания нейронных моделей долговременной памяти. Действительно, ансамблевую нейронную сеть можно рассматривать как структуру, реализующую функции распределенной ассоциативной памяти. Формирование ансамблей в такой сети соответствует запоминанию образов (признаков, объектов, событий, понятий), закодированных паттерном активности нейронов, а сформированные ансамбли являются их внутренним представлением. Процесс возбуждения всего ансамбля при активации части его нейронов можно интерпретировать как извлечение запомненной информации по ее части - ключу памяти. Модель памяти на основе ансамблевой нейронной сети обладает некоторыми свойствами, присущими биологической памяти, такими, как ассоциативность, распределенность, параллельность, устойчивость к шуму и сбоям, надежность.

Проводятся также структурные аналогии между ансамблевыми моделями нейронных сетей и строением коры головного мозга. Имеются экспериментальные данные о синаптической пластичности, постулированной Хеббом.

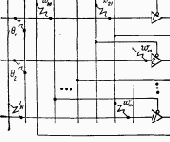

Модель ансамблевой сети состоит из большого количества нейроподобных элементов, каждый из которых обычно соединен со всеми другими элементами сети. Входной образ подается на сеть путем активации нужных нейроподобных элементов. В отличие от персептрона ансамблевая сеть может обучаться как с учителем, так и без него. Обучение производится по правилу Хебба (5) или одному из его вариантов. Значение коэффициента a (5) при обучении с учителем определяет величину подкрепления, а при обучении без учителя эта величина может быть установлена, например, постоянной. Отметим, что правило Хебба (5) формирует симметричную матрицу связей.

В процессе обучения при подаче на сеть набора входных образов - представителей среды - в сети формируются ансамбли, которые могут иметь сложную структуру, отражающую свойства среды. Действительно, связность внутри групп нейроподобных элементов, которые наиболее часто возбуждались одновременно, будем значительно выше, чем в среднем по сети. Так образуются ядра ансамблей, в которых накапливаются комбинации признаков, наиболее часто встречающиеся во входных образах. Их можно рассматривать как внутреннее представление образов-прототипов классов, объективно существующих во внешней среде. Более редкие комбинации возбужденных нейроподобных элементов образуют бахрому ансамблей, где фиксируются индивидуальные особенности образов, внутренний и внешний контексты и т. д.

Количество образов, которое можно запомнить в сети, сильно зависит от их размера, т. е. от количества нейроподобных элементов, которое активизируется образом, а также от степени корреляции образов. Аналитически и экспериментально показано, что количество стохастических образов, которое можно запомнить и восстановить в ансамблевой сети, при малом размере образа может значительно превышать число нейроподобных элементов сети.

При подаче на обученную ансамблевую сеть некоторого входного образа путем установки начального паттерна активности осуществляется восстановление наиболее близкого к нему образа из числа запомненных в сети. Сеть представляют самой себе, и в ней начинается обычный процесс (синхронный или асинхронный - в зависимости от используемого алгоритма) изменения состояний нейроподобных элементов. При этом из-за наличия только возбуждающих связей возникает проблема регулирования уровня активности сети, т. е. количества одновременно активных элементов. Для ее решения был предложен ряд внутрисетевых и внешних механизмов. Если уровень активности сети поддерживается примерно равным величине ансамбля, то межансамблевая конкуренция приводит к релаксации сети из начального к конечному устойчивому состоянию, соответствующему запомненному образу.

В ряде работ теоретически и экспериментально исследуются количественные характеристики функционирования ансамблевых сетей, например качество воспроизведения образа в зависимости от числа запомненных в сети образов и их размера, а также от степени близости к ним входного образа и т. д. Интересный метод аналитического исследования сетей с обратными связями предложен Хопфилдом.

2. Сеть Хопфилда. Хотя многочисленные результаты моделирования демонстрировали стабильность ансамблевых сетей с обратными связями и хеббовским правилом обучения (эволюцию сети к устойчивому состоянию), отсутствие математического обоснования такого введения препятствовало их популярности. Положение изменилось с появлением работ, где было определено подмножество нейронных сетей с обратными связями, которые гарантированно достигают устойчивого состояния.

В 1982 г. американский биофизик Джон Хопфилд опубликовал статью [134], где на основании аналогии между нейронными сетями и особым классом физических систем - спиновыми стеклами - ему удалось привлечь к анализу нейросетевых моделей мощный математический аппарат статистической физики. Это стимулировало вторжение в область моделирования нейронных сетей большого отряда ученых-физиков, которыми в настоящее время получено много интересных аналитических результатов.

Сам Хопфилд в упомянутой статье рассмотрел поведение модели полносвязной сети бинарных нейроподобных элементов с симметричными связями (wij = wji). Элементы функционировали в асинхронном режиме, т. е. каждый нейрон в случайные моменты времени с некоторой средней частотой определял свое состояние в соответствии с правилом (3). Это позволило описать поведение сети как релаксационный процесс, при котором минимизируется энергетическая функция Е (функция Ляпунова, гамильтониан) модели:

где wij - матрица связей; у и q - состояние и порог модельного нейрона. Действительно, изменение Е при изменении состояния нейрона (учитывая симметрию wij и полагая q=0)

Так как знак Dyi совпадает со знаком

В своей работе Хопфилд исследовал сеть с нейроподобными элементами, имеющими сигмоидную характеристику. Состояния нейронов такой сети изменяются одновременно и непрерывно, и сеть описывается

Понятно, что если сделать минимумами энергии заданный набор паттернов нейронной активности (образов), оба варианта сети Хопфилда смогут выполнять функции ассоциативной памяти, «скатываясь» к тому образу, в чей «бассейн притяжения» попадает начальный паттерн активности нейронов сети.

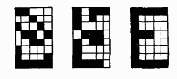

Например, на рисунке

буквы «Е». Активному нейрону соответствует заштрихованный элемент изображения. Из поданного на сеть зашумленного изображения (слева) восстанавливается правильное изображение (справа).

Как и следовало ожидать, одним из способов получения нужной энергетической функции является формирование матрицы связей в соответствии с вариантом хеббовского правила:

где zp - образы, которые надо запомнить в сети; L - их количество. Это правило, как и правило, предложенное Хеббом, обеспечивает формирование симметричной матрицы связей, однако постулирует увеличение веса связей между не только одновременно активными, но и одновременно неактивными нейронами, а также его уменьшение между нейронами, находящимися в разном состоянии. Такое правило допускает существование тормозящих модифицируемых связей между нейронами и даже переход возбуждающих связей в тормозящие. Оно позволяет сети автоматически саморегулировать уровень активности и работать с нулевыми порогами нейронов. Однако при этом значительно снижается емкость памяти сети: количество случайных образов, которое можно записать в сеть с возможностью восстановления, не превышает 0.14 количества нейронов. Кроме того, в дополнение к энергетическим минимумам, соответствующим запомненным образам, возникают ложные минимумы функции Е. Положение еще более осложняется для скоррелированных образов, которые после запоминания не становятся минимумами Е.

В настоящее время ведется интенсивная работа по улучшению характеристик модели Хопфилда, предлагаются ее интересные расширения и обобщения. Предпринимаются попытки создать алгоритмы обучения, позволяющие работать со скоррелированньми образами. В ряде работ приводятся обучающие правила, осуществляющие ортогонализацию и позволяющие запоминать в матрице связей произвольный набор линейно независимых образов. Такие правила, однако, приводят к усложненной нелокальной зависимости матрицы связей от записываемых образов.

Предлагаются способы отражения иерархии скоррелированных образов, существующей в реальном мире, в иерархическом дереве устойчивых состояний нейронной сети.

В ряде работ дан анализ появления в сети Хопфилда ложных образов. Они возникают вследствие присущего нейронной сети свойства накапливать в процессе обучения наиболее часто встречающиеся комбинации входных сигналов, формируя прототипные образы. Однако это свойство, очень полезное для ансамблевых сетей с малым уровнем активности, для сети Хопфилда приводит к отрицательному эффекту из-за большого уровня активности используемых в ней образов, а следовательно, значительного их перекрытия.

Предпринимаются поиски способов увеличения количества образов, которое можно запомнить в сети Хопфилда. Предлагалось ввести в модель «забывание» (например, ограничением величины весов). При этом новые записываемые в сеть образы будут вытеснять старые. Можно добиться увеличения числа запомненных образов ценой введения множественных связей. Однако радикального улучшения информационных характеристик сети Хопфилда, как показывает анализ, позволяет добиться первоначальный вариант хеббовского правила в сети с низким уровнем активности. Это подтверждается также данными исследователей, работающих с ансамблевыми сетями.

Интересным результатом увенчалась работа по преодолению таких серьезных с биологической точки ограничений модели, как полносвязность и симметрия. Оказалось, что сильно разреженная асимметричная версия сети Хопфилда может быть решена аналитически, и ее поведение качественно похоже на поведение полносвязной сети в области хорошего восстановления.

Для сети Хопфилда предложен также ряд механизмов работы с последовательностями. Основная проблема заключается в том, чтобы при запоминании отразить в статической структуре матрицы связей порядок следования входных образов, а при воспроизведении обеспечить их восстановление в нужном порядке. Это достигается формированием матрицы связей, в которой наряду со стационарными состояниями (симметричные связи) запомнены переходы между ними (асимметричные связи от предшествующего образа к последующему).

Для того чтобы разделить два типа динамики - релаксацию к устойчивому состоянию, соответствующему одному из образов последовательности, и переход к следующему образу- было предложено записывать переходы между состояниями в отдельной матрице связей и ввести временные задержки на сигналы, поступающие на входы нейронов через эту матрицу. Вследствие этого сеть сначала стабилизируется в некотором состоянии, а уже потом начинает «ощущать» притягивающее влияние следующего состояния и переходит в него. На таких сетях была продемонстрирована генерация, распознавание и подсчет элементов простейших последовательностей, однако пока не решена проблема обработки более сложных последовательностей, имеющих общие части, разветвления и повторения.

Развивая свои идеи о «коллективных вычислениях» в нейронных сетях, Хопфилд предложил использовать свойство сети минимизировать энергетическую функцию для решения оптимизационных задач. С этой целью сначала выбирается «нейронное» представление для конкретной задачи, т. е. исходя из ее условий состоянию нейронов присваивается смысл. Затем с учетом ограничений, налагаемых на задачу, конструируется энергетическая функция таким образом, чтобы в состояниях, представляющих возможные решения, она была пропорциональна стоимостной функции задачи. После этого из энергетической функции извлекаются связи wij и пороги qi, и конструируется соответствующая сеть. Так как в процессе функционирования сеть минимизирует свою энергию, динамика в пространстве состояний направлена на минимизацию соответствующей стоимостной функции. Поиск минимума энергии занимает всего несколько постоянных времени нейронов, поэтому сеть быстро достигает стабильного состояния, из которого декодируется решение задачи. Так как здесь в отличие от задачи ассоциативной памяти требуется нахождение не локального, а глобального энергетического минимума, существенной оказывается сигмоидность характеристик нейронов (бинарные нейроны здесь не подходят) и аналоговый характер их взаимодействия.

Решения, находимые такой аналоговой сетью, не самые лучшие, но достаточно близки к ним.

Несмотря на недостатки сети Хопфилда, предпринимаются попытки использовать ее аппаратные реализации для решения задач, требующих быстрого распознавания небольшого количества простых образов.

3. Машина Больцмана. Машина Больцмана представляет собой стохастический вариант сети Хопфилда. Бинарные нейроподобные элементы (блоки) трактуются здесь как представители элементарных гипотез, а веса - как слабые парные взаимоограничения между ними. Положительный вес связи указывает, что две гипотезы стремятся поддерживать друг друга, а отрицательный - на их несовместимость. Симметрия связей позволяет проанализировать поведение сети с использованием энергетической функции:

Энергию определенного паттерна активности можно интерпретировать как степень нарушения ограничений, присутствующих в проблемной области, со стороны конкретной комбинации гипотез или как стоимостную функцию, которая должна быть минимизирована для решения оптимизационной задачи.

Если зафиксировать состояния некоторых блоков, подав, таким образом, на сеть входное воздействие, остальные блоки начнут изменять свое состояние так, чтобы минимизировать энергию Е. Действительно, поступающая на каждый блок взвешенная сумма сигналов от активных блоков из-за симметрии связей совпадает с величиной разности между значениями, энергетической функции, зависящей от его собственного состояния:

Поэтому алгоритм изменения состояния бинарных нейроподобных элементов автоматически приводит к минимизации энергии Е.

При этом, однако, сеть может попасть в локальный минимум, что крайне нежелательно для оптимизационных задач. Чтобы сеть могла выбраться из локального энергетического минимума, в машине Больцмана применяется вероятностное правило срабатывания блоков:

где рi - вероятность нахождения i-ro блока в единичном состоянии;

Р (х) - сигмоидная функция;

T - параметр, аналогичный температуре.

При Т ® 0 это правило переходит в правило срабатывания детерминированных бинарных элементов (3), а при повышении температуры увеличивается вероятность перехода системы в состояние с большей энергией.

Если сеть с таким вероятностным правилом придет в состояние «теплового равновесия», относительные вероятности ее нахождения в двух глобальных состояниях будут подчиняться распределению Больцмана

где РA - вероятность нахождения сети в глобальном состоянии A;

ЕA - его энергия;

При низкой температуре система «предпочитает» состояния с низкой энергией, однако требуется много времени для достижения равновесия. При высоких температурах равновесие достигается быстрее, однако нет сильного предпочтения низким энергетическим состояниям.

Хороший способ нахождения глобального минимума получил название «имитация отжига» из-за аналогии с медленным охлаждением металла для получения низкоэнергетической кристаллической решетки. При этом сначала в сети устанавливают высокую температуру, при которой ее поведение почти случайно, а затем постепенно понижают температуру со скоростью, которая гарантирует, что система всегда будет близка к тепловому равновесию и не попадет в локальный минимум. При высокой температуре- сеть быстро находит зону энергетического ландшафта, где находится хороший минимум. При снижении температуры сеть находит в этой зоне близкий к глобальному минимум энергии.

Машина Больцмана может использоваться для классификации образов. При этом в ней, как и в многослойном персептроне, выделяют входные, выходные и внутренние (скрытые) блоки, однако для каждой прямой связи между блоками существует равная ей по величине обратная (симметричная) связь. Процесс распознавания состоит из следующих шагов:

- на входных блоках фиксируют входной образ;

- рандомизируют состояние скрытых и выходных блоков, а затем медленно понижают температуру;

- наблюдают за состоянием сети при конечной низкой температуре и собирают статистику состояний выходных блоков. На основании этой статистики делают вывод о входном образе.

Для работы алгоритма требуется обучающая выборка, состоящая из пар вход - выход, которые должна научиться ассоциировать сеть. Если после обучения зафиксировать на входных блоках один из входных образов, на выходных блоках должен появиться соответствующий выходной образ. Если подать на вход неизвестный образ, система на основе выявленных в обучающей выборке закономерностей должна провести правильное обобщение.

Практически каждый цикл обучения состоит из трех шагов.

1. Фаза тренировки. Для каждой пары образов фиксируются состояния входных и выходных блоков, а остальная часть сети подвергается отжигу к низкой температуре. Затем для каждой связи собирается статистика, какую часть времени pij+ были одновременно активны соединяемые ею блоки.

2. Фаза проверки. Вычисляется аналогичная величина pij-, однако теперь выходные блоки не зафиксированы и свободно меняют состояние.

3. Изменение связей. В хорошо обученной сети ее поведение будет идентично для обеих фаз. Если р+ и р- не совпадают для конкретной связи, ее изменяют:

Каждый цикл необходимо повторить много раз, пока матрица связей не стабилизируется в достаточной степени.

Оказывается, что при таком изменении весов осуществляется минимизация методом градиентного спуска теоретико-информационной меры различия между внешней средой и ее моделью, сформированной сетью:

где P+(Ia Щ Ob) - вероятность а-го состояния входных блоков и b-го состояния выходных, когда они фиксированы внешней средой;

P+(Ia | Ob) - вероятность b-го состояния выходных блоков при а-м состоянии входных, когда они фиксированы средой;

Р- (Оb | Ia) - соответствующая вероятность, когда фиксированы только входы.

Действительно, частная производная Q по каждому из весов имеет вид:

что позволяет обучать сеть с помощью описанной локальной процедуры.

К сожалению, алгоритм обучения машины Больцмана имеет типичные недостатки, присущие процедурам градиентного спуска в многопараметрических пространствах. Прежде всего это неточность вычисления градиента, обусловленная неполным достижением теплового равновесия и ограниченным временем сбора статистик.Из-за своей стохастичности алгоритм требует гораздо больших временных затрат по сравнению даже с алгоритмом обучения многослойного персептрона методом обратного распространения ошибки. Имеющаяся аппаратная реализация, однако, смягчает этот недостаток по крайней мере для небольших сетей. Известны примеры применения машины Больцмана для решения классических персептронных задач, таких, как задача «исключающего ИЛИ», обнаружение симметрии во входном образе и т. д., а также для распознавания речи.